Unternehmen mit Deepfakes täuschen

Missbrauch von KI zur Audio- und Videomanipulation

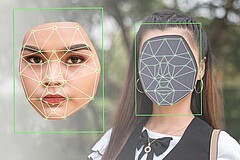

Mit dem Boom von Videokonferenzen wächst auch das Risiko für Deepfakes

© Mdv Edwards/stock.adobe.com

Videokonferenzen und Telefonkonferenzen gehören zum Arbeitsalltag von Unternehmen. Seit der Covid-19-Pandemie hat der Trend zum Homeoffice stark zugenommen. Viele Vor-Termine bei Kunden oder mit Dienstleistern, die bis 2020 noch vor Ort stattfanden, werden seitdem noch per Videokonferenz durchgeführt. Doch das Gegenüber auf dem Bildschirm oder die Stimme in der Telefonleitung kann eine virtuelle Marionette von Cyberkriminellen sein. KI-Technologie macht es möglich.

Mit wem spreche ich? Wer sitzt mir gegenüber?

Der CEO eines britischen Energieunternehmens wurde um umgerechnet 220 000 Euro betrogen. Die Anrufer fälschten die Stimme seines Vorgesetzten aus dem Mutterunternehmen und forderten einen Notfall-Geldtransfer an. Das Audio-Fake war so überzeugend, dass der CEO erst gar nicht misstrauisch wurde. Die Summe wurde jedoch nicht an das Büro des Mutterkonzerns überwiesen, sondern auf ein Drittanbieter-Bankkonto. Als der CEO seinen Fehler bemerkte, war es bereits zu spät, um das Geld zurück zu holen. Mit Deepfake-Videos kann man auch Firmenvorstände erpressen. Die Täter drohen etwa, die gefälschten Videos, die den Ruf der Opfer ruinieren würden, zu veröffentlichen, wenn kein Schweigegeld bezahlt wird. Ein weiterer Trick: Kriminelle rufen Beschäftigte in Unternehmen mit der gefälschten Stimme ihres Chief Information Officers an und bringen sie dazu, ihnen Passwörter und Berechtigungen bereitzustellen, mit denen sie die Kontrolle über vertrauliche Daten erlangen. Aus dem politischen Bereich sind Täuschungsversuche mit Fake-Videos bekannt: So wurde die damalige Regierende Bürgermeisterin von Berlin ebenso wie ihre Kollegen aus Mailand und Wien von einem falschen Vitali Klitschko per Videocall erreicht. Zwei der drei Angerufenen wurden im Lauf der Videokonferenz jedoch skeptisch und brachen die Schalte ab. Denn nicht jedes sogenannte Deepfake-Video ist bereits eine perfekte Täuschung.

So funktioniert es technisch

Der Begriff „Deepfake“ ist ein sogenanntes Kofferwort, das sich aus „Deep“ für „Deep Learning“ und „Fake“ wie Täuschung zusammensetzt. Die „Deep Learning“-Methode arbeitet mit künstlicher Intelligenz (KI). Sie gewinnt aus den Rohdaten wie etwa einem Video oder einem Telefon-Mitschnitt der Zielperson schrittweise immer feinere Merkmale. Diese Technologie kann aus unstrukturierten Daten lernen, etwa aus dem menschlichen Gesicht, indem sie Daten zu körperlichen Bewegungen erfasst und lernt, diese nachzuahmen. In einem weiteren Verarbeitungsschritt mit einem spezialisierten sogenannten „Machine Learning“-System wird dann ein gefälschtes Foto oder Video erstellt. Da die KI die Bilder immer wieder anhand der Trainingsdaten testet, werden die Ergebnisse von Versuch zu Versuch überzeugender. Technisch nennt man so etwas ein „Face-Swapping“-Verfahren. Diese KI-gestützten Techniken können auch Stimmen nachahmen. Beim sogenannten „Text-to-Speech“-Verfahren wird zu einem vorgegebenen Text ein Audio-Signal erzeugt, das sich sowohl für den Menschen als auch für eine automatische Sprechererkennung wie eine Zielperson anhört. Das macht Deepfake zu einer echten Gefahr.

Kriminelle müssen ihre Opfer gut studieren

Die Fakes in Video- und Audiokonferenzen können naturgemäß nicht vorproduziert werden, da die Person ja spontan sprechen und handeln sowie auf Fragen richtig antworten muss. Die KI legt „nur“ das Bild der gefälschten Person über das Bild des oder der Cyberkriminellen. Dieses darübergelegte Bild übernimmt die Mimik und Gestik der dahinter sitzenden Person. Das nennen die Fachleute „Face Reenactment“. Die Betrüger müssen jedoch die Ausdrucksweise oder auch die Gesten der Person gut studieren und nachahmen können. Die KI liefert ihnen nur das fast perfekte Bild dazu oder leiht ihnen bei Audio-Fakes die Stimme ihres Opfers.

Technische und kognitive Abwehr

So erkennen Sie Deepfake-Videos:

- Überprüfen Sie, ob eine Videokonferenz wirklich von einem Unternehmen angemeldet wurde, das Ihnen bekannt ist

- Informieren Sie Ihre Beschäftigten über das Phänomen der Deepfakes

- Schulen Sie ihre Belegschaft: Erklären Sie, an welchen Indizien man Deepfake-Videos erkennen kann

- Etablieren Sie ein Vier-Augen-Prinzip bei Überweisen, sodass niemals eine Person allein den Transfer einer größeren Summe an Dritte freigeben kann

- Informieren Sie sich etwa auf der Website des BSI über „Deepfakes – Gefahren und Gegenmaßnahmen“

Zum Erkennen von Deepfake-Videos gibt es Abwehrmöglichkeiten. Sie analysieren die Videobilder und lassen Fakes auffliegen. Damit haben sich die Anbieter von Cybersicherheitsprogrammen einen neuen Absatzmarkt erschlossen. Sie bieten Erkennungsalgorithmen an, die beispielsweise Verfälschungen am Gesicht im Bereich der Nase wahrnehmen. Diese entstehen, weil die Fake-KI zuerst zweidimensionale Gesichter erzeugt, die sie dann verzerrt, um räumliche Tiefe vorzuspiegeln. Aber es gibt auch eine Reihe von Anzeichen, an denen man auch ohne den Einsatz einer Gegenspionage-KI erkennen kann, ob ein Videobild gefälscht ist oder nicht. Es reicht zum Beispiel, wenn man darauf achtet, ob es ruckartige Bewegungen im Video gibt oder ob sich die Beleuchtung plötzlich verändert. Dadurch sollte man misstrauisch werden. Ein weiteres Indiz ist das Blinzeln der Augen. Blinzelt das Gegenüber niemals, könnte es sich um einen Fake handeln. Das stärkste Anzeichen ist jedoch, wenn die Stimme und die Lippenbewegungen nicht synchron sind. Falls mehrere dieser Merkmale auftreten, sollte man eine Videokonferenz umgehend beenden. „Wer in Live-Videos gegenüber seiner Kontaktperson misstrauisch ist, kann auch darum bitten, dass diese sich kurz an die Nase oder Wange tippt", rät übrigens der Verfassungsschutz. „Die KI ist bis dato selbst in ihrer besten Form nicht in der Lage, diese Animation darzustellen. Das Bild würde sichtlich verzerrt werden.“

WL (Stand: 28.04.2023)

Weitere Infos zum Thema gewerbliche Gebäudesicherheit

Zertifizierter Schutz vor Diebstahl, Brand und Hochwasser

Der Tresor ist ein sicheres Mittel zum Schutz von Wertgegenständen,...[mehr erfahren]

Chancen und Risiken von Smart Home im Gewerbe

Ein Einbruch oder ein Brandschaden kann für kleine und mittlere...[mehr erfahren]

Polizei berät neutral und kompetent

Jeder Betrieb und jedes Geschäft – egal wie groß oder klein – sollte...[mehr erfahren]

Diagnose: Hohe Einbruchsgefahr

Arztpraxen sind in Deutschland seit der Einführung der Praxisgebühr...[mehr erfahren]

Durch individuelle Konzepte sollen Baurecht und Arbeitnehmerschutz besser aufeinander abgestimmt werden

Beim betrieblichen Brandschutz treffen die Anforderungen des...[mehr erfahren]

Aktivitäten

Service

Präventionsvideos

"Ein Bild sagt mehr als tausend Worte". Und gerade mit bewegten Bildern werden wir alle viel leichter erreicht als mit nüchternen Informationsmaterialien, die nur den Verstand ansprechen. Hier finden Sie die Präventionsvideos.

Schützen Sie Ihre Immobilie gegen Einbruch!

Erklärung einschlägiger Präventions-Begriffe

Beliebte Artikel für Einbruchschutz in Untenehmen

So schützt man sich am besten

Heinrich Hauner ist Kriminalhauptkommissar beim Präsidium München....[mehr erfahren]

„Jede Kette ist nur so stark wie ihr schwächstes Glied!“

Besonders für Unternehmen und Geschäfte kommt es auf eine gute...[mehr erfahren]

Die Videoüberwachung von Betriebsgebäuden ist nur unter bestimmten Bedingungen sinnvoll – und erlaubt

Einbruchsgefahr, Diebstähle durch Supermarktkunden, Unterschlagungen...[mehr erfahren]